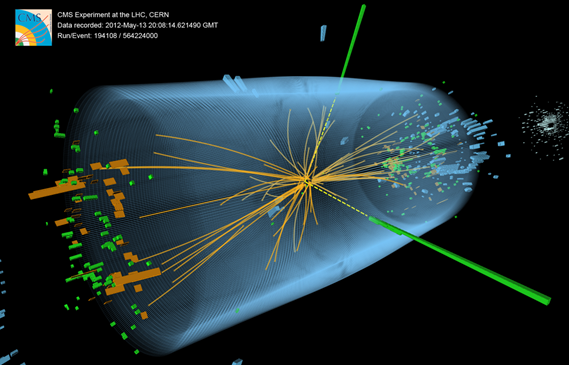

Las colisiones en el Gran Colisionador de Hadrones (LHC) generan partículas que decaen en formas complejas o en otras partículas. Los instrumentos del LHC registran el paso de cada partícula como una serie de señales electrónicas y envían los datos al Centro de Datos del CERN para realizar una reconstrucción digital: los informes son guardados como un evento de colisión.

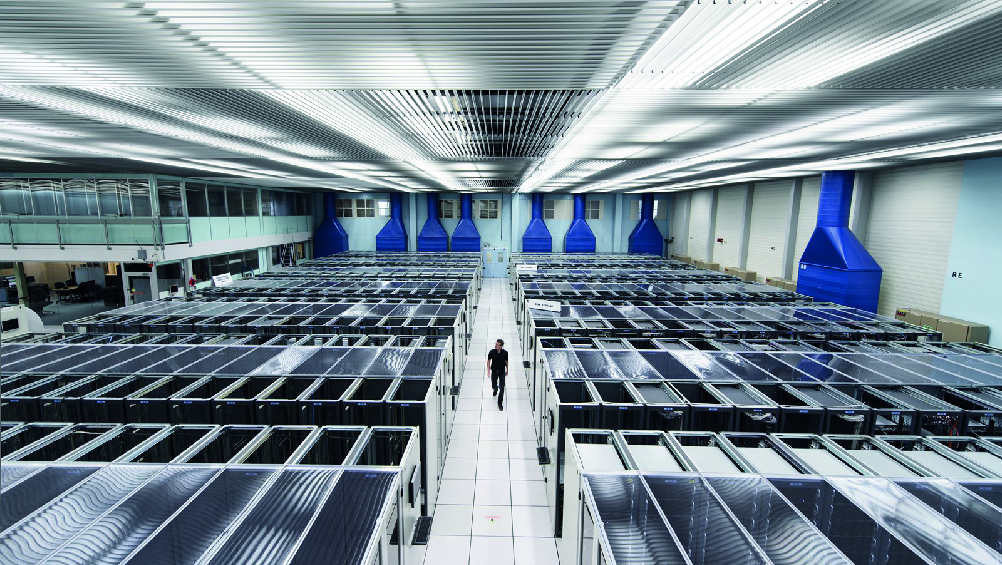

Hasta mil millones de colisiones de partículas pueden ocurrir cada segundo al interior de los detectores del LHC. Son tantos eventos, que se necesita un sistema de prefiltrado que reconozca los eventos potencialmente más interesantes, pero incluso así los experimentos del LHC producen alrededor de 90 petabytes (90 millones de gigabytes) de datos al año. Como comparación, todo el material impreso del mundo pesa aproximadamente 200 petabytes. Eso significa que, en un año, los equipos de investigación del LHC deben analizar una información equivalente a casi la mitad de todo el material impreso del mundo.

Tal cantidad de datos exige herramientas de análisis de datos de punta. Una de las tareas del equipo de investigación del Instituto Milenio Saphir busca precisamente eso: desarrollar sistemas de análisis de datos que faciliten el procesamiento del gigantesco volumen de información generado por los experimentos del LHC.

Visualización en 3D de un evento de colisión de protones registrado en el detector CMS del Gran Colisionador de Hadrones en 2012. Créditos: Thomas McCauley, Lucas Taylor y CERN. Fuente: CERN.